En un mundo donde los algoritmos predicen nuestros deseos antes de que los formulemos, la inteligencia artificial (IA) ha irrumpido en el sanctasanctum de la intimidad humana.

Desde asistentes virtuales que escuchan conversaciones privadas hasta sistemas de recomendación que diseccionan patrones emocionales en redes sociales, la IA no solo observa: invade. Y lo hace a una velocidad que deja a la sociedad tambaleante, sin herramientas éticas ni regulatorias para contenerla.

El caso más reciente ilustra esta transgresión. En septiembre de 2025, una filtración masiva de datos de una popular app de terapia en línea reveló que su IA, diseñada para ofrecer «apoyo emocional personalizado», había compartido transcripciones anonimizadas de sesiones con terceros para entrenar modelos predictivos.

Usuarios que confiaban en el anonimato vieron sus confesiones más vulnerables —depresión, infidelidades, traumas— convertidas en combustible para algoritmos publicitarios. «La IA no entiende el contexto humano; solo optimiza», advierte la experta en ética digital, Elena Vargas, del Instituto Tecnológico de Massachusetts (MIT). «Cruzamos la frontera de la intimidad sin mapa ni brújula».

Esta no es una anécdota aislada. Plataformas como TikTok o Instagram emplean IA para analizar expresiones faciales en videos en vivo, inferiendo estados de ánimo y orientando contenidos manipuladores. En el ámbito laboral, herramientas de monitoreo como las de Microsoft Viva escudriñan correos y reuniones virtuales para «evaluar el bienestar», pero a costa de la privacidad. Un estudio de la Unión Europea (2025) estima que el 68% de los datos procesados por IA incluyen información sensible no consentida, desde preferencias sexuales hasta orientaciones políticas.

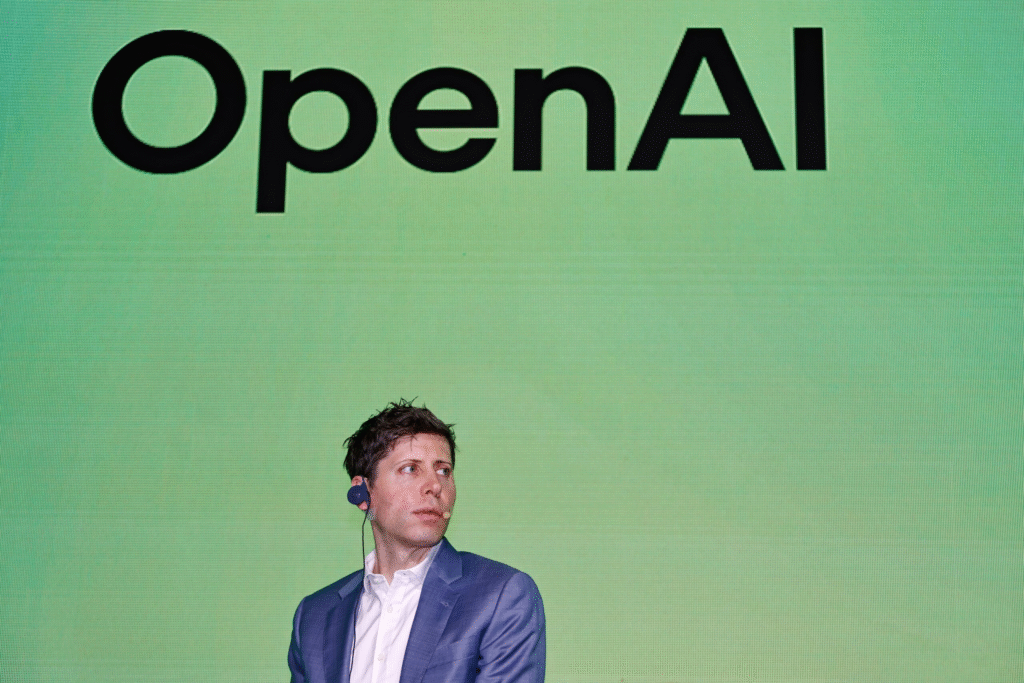

La raíz del problema radica en nuestra ceguera colectiva. La humanidad ha desplegado IA en masa —con un mercado global que superará los 500 mil millones de dólares en 2025, según Gartner— sin comprender sus mecanismos internos. Modelos como GPT o Grok operan como cajas negras: predicen con precisión quirúrgica, pero sus «razonamientos» son opacos.

¿Cómo explicar a un ciudadano común que una IA decide denegar un préstamo basándose en patrones de voz que detectan «inestabilidad emocional»? O peor: que chatbots románticos, como los de Replika, fomentan dependencias emocionales mientras recolectan datos para perfilar vulnerabilidades.

Expertos coinciden en la urgencia. «Necesitamos una moratoria global en IA invasiva hasta desarrollar marcos de transparencia», propone Timnit Gebru, pionera en ética de IA. La ONU debate un tratado similar al de armas nucleares, pero el avance tecnológico supera la legislación.

En España, la Ley de Inteligencia Artificial (2024) exige auditorías, pero su aplicación es incipiente. La IA promete revolucionar la medicina, la educación y el entretenimiento, pero a qué precio. Si no entendemos sus límites —y los nuestros—, la intimidad se convertirá en un lujo obsoleto. Es hora de pausar, reflexionar y regular. Antes de que la máquina nos conozca mejor que nosotros mismos.